La producción del lenguaje es un fenómeno cerebral altamente complejo que ha desconcertado a los investigadores que intentan comprenderlo. Uno de los desafíos para los creadores de dispositivos de generación de habla es distinguir las redes neuronales, sobre todo las áreas que controlan los movimientos de la boca, la mandíbula o la lengua, así como las zonas que procesan la audición cuando se escucha la voz propia.

Recientemente, un grupo de investigadores de la Universidad de Nueva York ha realizado descubrimientos fundamentales que ayudan a desentrañar este enigma y los están utilizando para desarrollar una tecnología de reconstrucción vocal que puede recrear las voces de personas que han perdido la capacidad de hablar.

Este equipo ha utilizado complejas redes neuronales para reconstruir el habla a partir de lecturas cerebrales y, posteriormente, ha empleado esta reconstrucción para analizar los procesos que impulsan el habla humana.

Descifrar procesos de habla y audición, el reto de este proceso

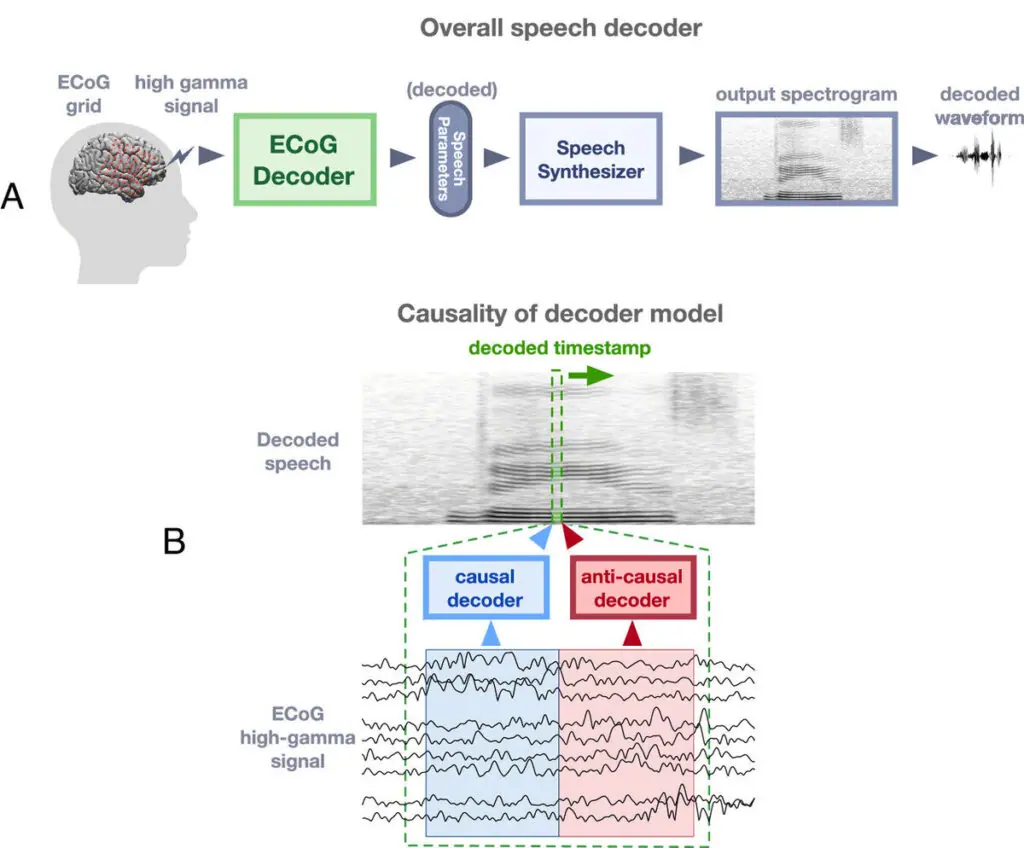

Como prueba de ello, se publicó un estudio en el que los investigadores desentrañan los procesos de retroalimentación (feedback) y y avance (feedforward) durante la producción del habla. Utilizando una arquitectura innovadora de aprendizaje profundo en registros neuroquirúrgicos de pacientes humanos, el equipo empleó un sintetizador basado en reglas que se puede diferenciar para descifrar los parámetros del habla a partir de señales corticales.

Al implementar estructuras de redes que distinguen entre convoluciones temporales causales (que utilizan señales neuronales actuales y pasadas para decodificar el habla actual), convoluciones anticausales (que emplean señales neuronales actuales y futuras) o una combinación de ambas (no causales), los expertos analizaron las contribuciones del feedforward y la retroalimentación en la producción del habla.

Este enfoque de avanzada no sólo decodificó parámetros interpretables del habla, sino que también proporcionó información sobre los campos receptivos temporales de las regiones corticales reclutadas. Sorprendentemente, los hallazgos cuestionan las nociones predominantes que segregan las redes corticales de retroalimentación y alimentación.

Pero, la magnitud de los hallazgos supera la ficción. De acuerdo con los investigadores, los pacientes no solo recuperarán una voz genérica después de perderla; recuperarán su propia voz. Esto es posible gracias a una red neuronal profunda que toma en consideración un espacio auditivo latente y puede entrenarse con solo unas pocas muestras de la voz de un individuo, como un video de YouTube o una grabación de una reunión de Zoom.

Para lograrlo, desarrollaron prótesis capaces de leer la actividad cerebral y convertirla directamente en habla. Aunque muchos investigadores trabajan en dispositivos similares, el prototipo de la NYU presenta una diferencia crucial: tiene la capacidad de recrear la voz del paciente utilizando solo un reducido conjunto de datos de grabaciones, logrando un nivel impresionante de fidelidad.

Artículos Relacionados:

La ciencia dice ahora que el cerebro nunca para de crecer

Crean el Google Earth del cerebro: así es el primer atlas cerebral en 3D

Científicos descubren una nueva clase de células de memoria en el cerebro

Hipertensión, vinculada al ACV y otros daños en cerebro

Así actúan las ‘hormonas del estrés’ sobre el cerebro